HTTPS站点如何做才能让百度蜘蛛抓取

时间:2016-04-11HTTPS站点如何做才能让百度蜘蛛抓取

我们可以根据user-agent来判断spider。然后做301/302定向,百度spider引擎定向到HTTP

非百度SPIDER 定向到HTTPS

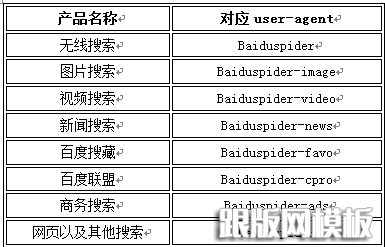

目前百度的度各个产品使用的user-agent:

目前有两种方法

第一种方法:可以采用.htaccess 301重定向

RewriteEngine On

# BEGIN Force SSL

RewriteCond %{HTTPS} !on [NC]

RewriteCond %{HTTP_USER_AGENT} !( Baiduspider| Baiduspider-image | Baiduspider-video | Baiduspider-news | Baiduspider-favo | Baiduspider-cpro | Baiduspider-ads | Baiduspider) [NC]

RewriteRule (.*) https://%{SERVER_NAME}%{REQUEST_URI} [R=301,NC,L]

# END Force SSL

第二种方法:php的 $_SERVER['HTTP_USER_AGENT']来进行判断

<?php $tmp = $_SERVER['HTTP_USER_AGENT'];

if (strpos($useragent, 'baiduspider') !== false){ return 'baiduspider'; }

if (preg_match(“#(baiduspider)#si”, $_SERVER['HTTP_USER_AGENT'])) { header(“HTTPS/1.1 301 Moved Permanently”); header(“Location: http://www.XXXXX.com/”); exit; }}

采用HTTPS的站点都是要求安全性能的站点,所以站长还是采用形式,需要安全的站点采用二级域名,其余用目录形式表现。

相关文章

百度站长平台:该站点为低质站点,暂不可添加,请持续优化后,再行尝试最近新抢注了一个域名,到百度站长平台添加网站时候提示:该站点为低质站点,暂不可添加,请持续优化后,再行尝试。这种情况是啥问题? 经过一番查看,此域名没

百度站长平台:该站点为低质站点,暂不可添加,请持续优化后,再行尝试最近新抢注了一个域名,到百度站长平台添加网站时候提示:该站点为低质站点,暂不可添加,请持续优化后,再行尝试。这种情况是啥问题? 经过一番查看,此域名没 网站优化如何运用事件舆论做网络营销网站优化如何运用事件舆论来做网络营销,今天跟版网小编来告诉你以下几点做事件关联起来做好文章,从而获得流量 1、要利用网络热门事件推广网站 首先要找到热门事

网站优化如何运用事件舆论做网络营销网站优化如何运用事件舆论来做网络营销,今天跟版网小编来告诉你以下几点做事件关联起来做好文章,从而获得流量 1、要利用网络热门事件推广网站 首先要找到热门事 百度https认证提示"请将您的http站点301重定向到https站点"的解决办法最近想把一个网站改造成https访问,但是一些都做好了,去百度站长平台认证https,结果怎么提交都是出现请将您的http站点301重定向到https站点,在百度站长社区提

百度https认证提示"请将您的http站点301重定向到https站点"的解决办法最近想把一个网站改造成https访问,但是一些都做好了,去百度站长平台认证https,结果怎么提交都是出现请将您的http站点301重定向到https站点,在百度站长社区提 HTTPS站点如何在平台提交数据做了HTTPS站点,在平台如何提交数据,如何使用工具,下面再给大家细细讲解: 1 、 HTTPS 站点请先使用平台 HTTPS 认证工具,经过平台工具验证后,可加速搜索对 H

HTTPS站点如何在平台提交数据做了HTTPS站点,在平台如何提交数据,如何使用工具,下面再给大家细细讲解: 1 、 HTTPS 站点请先使用平台 HTTPS 认证工具,经过平台工具验证后,可加速搜索对 H https站点如何建设才能对百度友好2015年5月25日,百度站长平台发布公告,宣布全面放开对https站点的收录,https站点不再需要做任何额外工作即可被百度抓收。采用了本文之前建议的https站点可以关

https站点如何建设才能对百度友好2015年5月25日,百度站长平台发布公告,宣布全面放开对https站点的收录,https站点不再需要做任何额外工作即可被百度抓收。采用了本文之前建议的https站点可以关 如何让网站改版不会被百度降权?在SEO优化中我们最烦的最怕的莫过于网站改版了,网站改版后一定会被降权,降权后恢复的时间长短取决于SEOer的技术深浅!当然那种大流量的门户网站除外,那种网站

如何让网站改版不会被百度降权?在SEO优化中我们最烦的最怕的莫过于网站改版了,网站改版后一定会被降权,降权后恢复的时间长短取决于SEOer的技术深浅!当然那种大流量的门户网站除外,那种网站

百度站长平台“你无权访问该页面,点击确定按钮返回首页”小编在百度站长平台添加网站时候,提示:你无权访问该页面,点击确定按钮返回首页,如下图所示: 小编觉得很奇怪,因为之前添加了十多个网站都没有问题,百度搜了一下,也

百度站长平台“你无权访问该页面,点击确定按钮返回首页”小编在百度站长平台添加网站时候,提示:你无权访问该页面,点击确定按钮返回首页,如下图所示: 小编觉得很奇怪,因为之前添加了十多个网站都没有问题,百度搜了一下,也